Noel Röhrig

Softwareentwickler auf Rädern 🚎

03.02.2026 | 5 min Lesezeit

KI-Integrationen mit echtem Mehrwert

Out of the box Lösungen reichen nicht mehr aus

Aktuell nutzen rund ein Drittel aller Unternehmen in Deutschland KI, wobei gemeinhin erwartet wird, dass die Bedeutung von KI in Zukunft deutlich zunimmt. Der erste „Wow-Effekt“ mit der Veröffentlichung von ChatGPT im Jahr 2022 ist vorbei und es ist an der Zeit, den aktuellen Stand in der KI-Landschaft nüchtern zu betrachten und Möglichkeiten für echte Wertschöpfung zu evaluieren.

Was ist “KI” heutzutage überhaupt

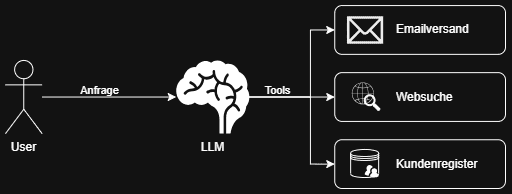

Nach wie vor stecken hinter jeder KI-Anwendung schlichtweg „Large Language Models“ (LLMs), die durch intensives Training Wortteil für Wortteil generieren. Vereinfacht gesagt wird dabei aufgrund komplexer statistischer Wahrscheinlichkeiten der nächste Wortteil ermittelt. Somit kann der Satz „Die Tomate ist“ wahrscheinlich mit „rot“ oder „lecker“ beendet werden – allerdings eher nicht mit „klug“. Wirklich wertvoll werden diese LLMs erst, wenn man ihnen Werkzeuge (oft auch: Tools) in die Hand gibt, mit denen Datenzugriff, Berechnungen oder Integrationen mit anderen Softwaresystemen möglich werden. Die Fähigkeit, diese Tools aufzurufen und mit entsprechenden Ergebnissen weiterzuarbeiten, wurde in den zugrunde liegenden LLMs in den letzten Jahren immer mehr antrainiert.

Die KI-Chatfenster, mit denen wir in unserem Alltag so häufig konfrontiert sind, sind also weitaus mehr als nur das LLM, das sich die Wortfetzen einer Unterhaltung zusammengeneriert. Hinter diesen KI-Anwendungen stehen klassische Softwareprojekte: Hier werden Daten abgerufen, verarbeitet und gespeichert – und bei Bedarf wird über APIs auf externe Software zugegriffen. Anders ist an der Stelle lediglich die Orchestrierung, wie der zugrunde liegende Code aufgerufen wird. Statt eines Buttons im Frontend, der im Hintergrund Daten aus einer Datenbank zieht und darstellt, interpretiert ein LLM die Intention des Endnutzers, ermittelt die wahrscheinlich passendste Funktion, um sich die nötigen Daten zu ziehen, und stellt diese in Textform dar.

Integrationen von der Stange der KI-Anbieter

Die Anbieter der klassischen LLMs sind sich natürlich auch bewusst, dass ihre Chats nur wirklich Wert bringen, wenn Unternehmen ihre Software mit dem LLM im Chat integrieren können. Deshalb gibt es bei OpenAI mittlerweile Konnektoren für HubSpot, Suchmaschinen oder Immobilienplattformen, bei Gemini kann man seine Google Suite verbinden und Microsoft versucht, Copilot in Outlook und Co. einzubinden.

Tanzt man jedoch aus der Reihe und hat noch eigens gehostete Datensätze oder strukturiert seine Daten anders, als es üblich ist, dann fallen die oberflächlichen Lösungsansätze der Anbieter oft flach. Auch fehlt bei den Standardlösungen die Möglichkeit, seine Datensätze dem LLM auch für schwammigere Anfragen über Vektorsuchen zur Verfügung zu stellen. Hierzu aber in einem späteren Blogeintrag mehr.

Am kritischsten dürfte für die meisten Unternehmen aber die Frage nach dem Datenschutz und der Datensouveränität sein. Hierbei macht man sich an gleich zwei Punkten angreifbar: Einerseits liegen die Chats, also die konkreten Anfragen und Antworten, unverschlüsselt bei den Anbietern und können oft sogar für weitere Trainings der KI genutzt werden. Andererseits öffnet man auch gleich seine Datensätze über die Integrationen an den Anbieter. Diesen Aspekt kann man noch breit ausdiskutieren; mindestens ist es aber rechtlich oft problematisch.

Weitere Nachteile wie Vendor-Lock-in, Latenzen und Rate-Limits sind dabei noch nicht einmal erwähnt.

Custom Solutions

Als Alternative bietet es sich an, eine eigene Lösung zu entwickeln. Diese kann proprietär oder in der (europäischen) Cloud gehostet und mit einem LLM verknüpft werden. Das LLM ist auch hier im Idealfall nicht direkt von OpenAI, Anthropic oder Google gehostet, sondern auch in der eigenen Cloud-Umgebung ansässig. Für besonders sensible Daten lassen sich offene LLMs auch proprietär auf geeigneter Hardware hosten.

Die Implementierung einer solchen KI-Anwendung bietet viele Vorteile gegenüber den Standarddiensten der üblichen KI-Anbieter. Die Einsatzzwecke gehen weit über die üblichen Chats hinaus; mit den richtigen Voraussetzungen lassen sich LLMs viel tiefer in die Geschäftsprozesse eines Unternehmens integrieren. Zudem hat man volle Kontrolle über die eigenen Daten und die Anfragen an das LLM sowie dessen Antworten werden nur bei Bedarf in der eigenen Cloud-Umgebung gespeichert.

Bei der Implementierung einer individuellen KI-Anwendung sind wir schnell wieder bei einem klassischen Softwareprojekt. Es müssen Schnittstellen, Datenverwaltungen und -projektionen entwickelt werden und oft braucht es auch noch ein Frontend für Interaktionen mit dem KI-System. Lediglich das Eingießen des LLMs in die Prozesse bedarf einer neuen Denkweise und Anpassung – dazu werde ich aber auch in den folgenden Blogeinträgen ausführlich aufklären.

Für einen Einblick in die Möglichkeiten, die LLMs bieten, wenn sie durch eigens geschriebene Software erweitert werden, empfehle ich einen Blick auf das OpenClaw-Projekt. Es ist eine experimentelle Plattform, die lokal läuft und einen persönlichen Assistenten darstellt. Über verschiedene Konnektoren, Integrationen und Vollzugriff auf die Maschine, auf der es installiert ist, hat das System viele Möglichkeiten. Das heißt: Online-Recherchen, Installation von Programmen, Weiterentwicklung von sich selbst, Abarbeiten von routinierten Aufgaben oder Smart-Home-Steuerung – also ein bisschen das, was man sich von KI im Silicon Valley oft erträumt. Und möglich ist das nicht durch ein bahnbrechendes neues LLM oder gar einen gänzlich neuen KI-Ansatz. Hintenrum orchestriert ein stinknormales, austauschbares LLM den Aufruf von vielen Tools. Mächtig wird diese KI-Anwendung erst durch die ca. 400.000 Zeilen Code um das LLM herum.

Ausblick

Die Zukunft der KI liegt in der Frage, wie man ein LLM auf eine wertschöpfende Weise in seine Softwarelandschaft integrieren kann. Standardlösungen sind oft unzulänglich und schöpfen nicht das volle Potenzial der LLMs aus.

Wir bei codeunity erschließen diesen Weg bereits für uns und haben in den letzten Monaten intensiv mit Semantic Kernel und der Azure AI Foundry dieses Feld erkundet. Mit dieser Blogreihe möchte ich euch mitnehmen, um unsere Learnings näher zu beleuchten.

Quellen

- Bundesnetzagentur KI in Unternehmen

- Openclaw